HBase數據讀寫流程 構建高效數據處理與存儲支持服務

HBase作為分布式、面向列的開源NoSQL數據庫,以其高可靠性、高性能和可擴展性,在當今的大數據生態系統中扮演著至關重要的角色。其核心設計理念源于Google的Bigtable論文,并在Hadoop生態系統中實現了與HDFS的深度集成。理解HBase的數據讀寫流程,是構建高效、穩定的數據處理與存儲支持服務的基礎。

一、 HBase核心架構概覽

在深入讀寫流程之前,需簡要了解其架構。HBase采用主從(Master-Slave)架構:

- HMaster:負責元數據(如表結構)管理、RegionServer的負載均衡以及故障恢復。

- RegionServer:數據存儲和讀寫請求的實際處理者。每個RegionServer管理多個Region(數據分片)。

- Region:表數據的水平分區,是負載均衡和分布式存儲的基本單位。隨著數據增長,Region會分裂。

- ZooKeeper:作為協調服務,負責維護集群狀態(如活躍的HMaster、RegionServer列表)、元數據入口以及分布式鎖。

- HDFS:作為底層持久化存儲,提供高可靠的數據存儲支持。

二、 數據寫入流程詳解

HBase的寫入操作(如Put)遵循一個高效且保證一致性的路徑,旨在實現快速的隨機寫入。

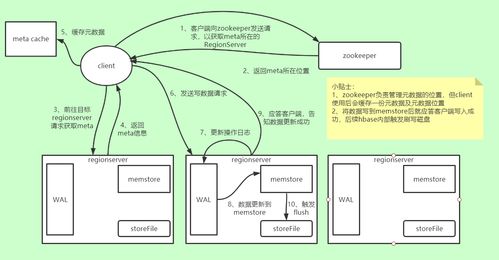

- 客戶端發起請求:客戶端(Client)首先從ZooKeeper獲取

hbase:meta表的位置信息(該表記錄了所有用戶表Region的分布信息)。

- 定位目標Region:客戶端查詢

hbase:meta表,確定將要寫入的行鍵(RowKey)所屬的Region及其所在的RegionServer。此信息會被緩存以加速后續請求。

- 發送寫請求至RegionServer:客戶端將寫請求(包含行鍵、列族、列限定符、值、時間戳等)直接發送給目標RegionServer。

- RegionServer處理寫入:

- 寫入WAL(Write-Ahead Log):為保證數據持久性,防止內存數據丟失,首先將數據變更順序追加寫入到HDFS上的WAL文件中。這是“先寫日志”原則的體現,是恢復機制的關鍵。

- 寫入MemStore:數據被寫入到對應Region中特定列族(Column Family)的內存緩沖區——MemStore中。MemStore中的數據按行鍵排序存儲。寫入到此即對客戶端返回成功,實現了低延遲。

- MemStore刷寫(Flush):當MemStore的大小達到閾值(

hbase.hregion.memstore.flush.size),或整個RegionServer的MemStore總和達到一定比例時,系統會異步地將MemStore中的數據順序寫入HDFS,生成一個新的存儲文件——HFile。刷寫完成后,對應的MemStore被清空,并在WAL中做一個標記。此過程將隨機寫轉換為順序寫,極大提升了HDFS的寫入效率。

- 后臺合并與壓縮:隨著刷寫次數增多,會產生大量小文件(HFile)。HBase會定期執行Minor Compaction(合并數個相鄰的較小HFile)和Major Compaction(合并一個Region內一個列族的所有HFile,并清理已刪除或過期的數據),以減少文件數量、提升讀性能并回收空間。

三、 數據讀取流程詳解

HBase的讀取操作(如Get、Scan)旨在從多級存儲結構中高效定位數據。

- 客戶端定位Region:與寫入流程類似,客戶端首先通過ZooKeeper和

hbase:meta表定位目標行鍵或掃描范圍所在的RegionServer。

- 發送讀請求至RegionServer:將請求發送給相應的RegionServer。

- RegionServer并發讀取:RegionServer收到請求后,會從多個可能的數據源中并行查找數據,并按照時間戳等規則合并結果。讀取順序遵循一個層次結構(可視為一個“讀取合并”過程):

- Block Cache:首先檢查讀緩存。Block Cache緩存的是從HFile中讀取的數據塊(Block),采用LRU策略。適合頻繁訪問的熱點數據。

- MemStore:然后查詢對應列族的MemStore(其中包含尚未刷寫到磁盤的最新數據)。

- HFile(磁盤):在HDFS上的HFile文件中進行查找。為了加速,HBase使用了布隆過濾器(Bloom Filter)來快速判斷某個行鍵是否存在于一個特定的HFile中,避免了不必要的磁盤IO。索引(每個HFile有行鍵索引)和數據塊(Block)的本地化(Data Locality)也優化了讀取速度。

- 結果合并與返回:將從Block Cache、MemStore和多個HFile中讀取到的數據(可能包含同一單元格的多個版本)進行合并,根據時間戳或版本數等條件篩選出最終結果,返回給客戶端。

四、 對數據處理與存儲支持服務的啟示

深入理解HBase讀寫流程,對于設計和運維數據處理與存儲服務具有重要指導意義:

- 高性能設計:

- 寫優化:通過WAL+MemStore模型,將隨機寫轉化為內存寫和順序磁盤寫,支撐高吞吐寫入。設計RowKey時應考慮均勻分布,避免寫入熱點。

- 讀優化:多層緩存(Block Cache, MemStore)和高效索引(布隆過濾器、行鍵索引)保障了隨機讀性能。根據業務特點調整緩存大小和塊大小至關重要。

- 高可靠性與一致性保障:WAL機制確保了即使在RegionServer宕機后,未刷寫的數據也能恢復。HDFS的多副本機制為數據提供了底層存儲容錯。

- 可擴展性支撐:Region自動分裂和HMaster的負載均衡使得集群可以近乎線性地通過增加機器來擴展存儲容量和吞吐量。

- 服務運維關鍵點:

- 監控MemStore刷寫頻率、Compaction壓力,防止寫入阻塞。

- 合理設置Major Compaction周期,平衡讀性能提升與IO開銷。

- 確保RegionServer與HDFS DataNode的“數據本地化”,減少網絡傳輸。

- 根據訪問模式(讀多寫少/寫多讀少)優化Block Cache與MemStore的配置。

結論

HBase的數據讀寫流程是其高性能、高可靠特性的工程化體現。從客戶端的路由尋址,到服務端的WAL持久化、內存緩沖、多級存儲與緩存檢索,這一整套精密的協作機制,共同構成了一個能夠處理海量數據、支持隨機實時訪問的強大存儲引擎。在構建企業級的數據處理與存儲平臺時,充分理解和利用這些機制,是確保服務能夠穩定、高效支撐上層業務應用(如實時監控、用戶畫像、消息存儲等)的關鍵所在。

如若轉載,請注明出處:http://www.51dwgw.cn/product/68.html

更新時間:2026-02-17 16:39:48